Step3-VL-10B: VLM от stepfun.ai

Пока индустрия одержима гигантоманией и соревнуется, у кого больше параметров, Stepfun решили пойти против течения.

Встречайте, Step3-VL-10B — компактная VL-модель, которая по заявлениям разработчиков не просто конкурирует, а буквально уделывает модели в 10–20 раз тяжелее, включая таких титанов, как Gemini 2.5 Pro и GLM-4.6V.

Звучит как маркетинговый хайп, но под капотом есть интересные инженерные решения, хоть и с хитринкой.

Архитектура

Конструкция из кастомного визуального PE-lang энкодера на 1.8B параметров и Qwen3-8B (что уже половина успеха, учитывая мощь Qwen) в качестве декодера.

В отличие от многих, кто замораживает визуальную часть, Stepfun разморозили все и тренировали модель в один прогон на 1,2 трлн. токенов. Это позволило визуальной и языковой частям модели не просто сосуществовать, а реально срастись и притереться друг к другу.

После этого модель прогнали через адский RL-цикл (RLVR+RLHF) на 1400+ итераций, чтобы модель научилась жестко ризонить.

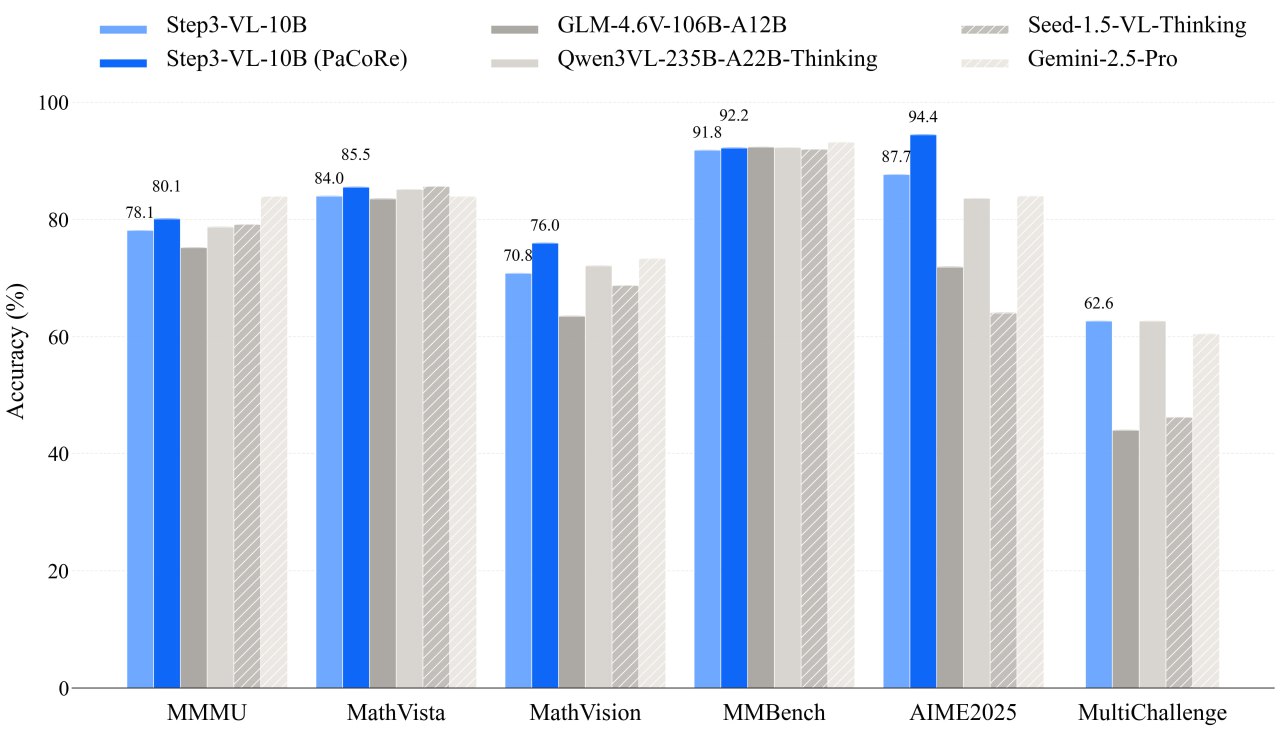

Тесты

В бенчмарках цифры действительно страшные (в хорошем смысле) для такого размера:

- MMMU: 78.11 (SeRe) / 80.11 (PaCoRe).

- MathVista: 83.97

- AIME 2025: 87.66 (SeRe) / 94.43 (PaCoRe)

- OCRBench: 86.75 (отлично читает документы).

Для сравнения: GLM-4.6V на 106B выдает на MMMU только 75.20.

Инженерная хитринка кроется в методологии тестирования. Видите в результатах тестов пометку PaCoRe?

PaCoRe (Parallel Coordinated Reasoning): Чтобы получить топовые цифры, модель использует test-time compute. Она запускает 16 параллельных роллаутов, собирает доказательства из разных веток и синтезирует ответ.

На инференсе это будет стоить вам в 16 раз «дороже» по ресурсам, чем обычный прогон. В стандартном режиме (SeRe) модель все еще хороша, но уже не выглядит как «убийца всех топов».

Кстати, Stepfun честно признались, что в отчетах накосячили с бенчмарками конкурента Qwen3VL-8B из-за неверного max_tokens. Извинились, обещают пересчитать. Это добавляет доверия, но напоминает, что бенчмарки — дело тонкое.

В общем, модель — отличный кандидат для локального использования: есть OpenAI-compatible API и vLLM поддерживается (PR вмержили).

⚠️ Если модель зацикливается при генерации — обновите конфиг, там был баг с eos_token_id, который уже пофиксили.

📌Лицензирование: Apache 2.0 License.

Модель

Arxiv

Demo

https://t.me/BusinessNetwork_robot?start=G7X296

#AI #ML #VLM #STEP3 #StepFunAI

📱 Наш Телеграм канал: https://t.me/bninstrum

🔵 Канал VK: https://vk.ru/club195425868